原生运行于Nvidia BlueField-4 DPU上的庞大AI作系统,整合了传统存储层级,提供共享的Pod级KV缓存,支持确定性访问,支持长上下文、多回合和多代理推理。

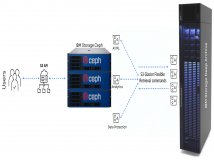

人工智能作系统公司Vast Data宣布了一种新的推理架构,支持英伟达推断上下文内存存储平台——为长寿且代理型AI时代的部署提供支持。该平台是一类用于超大规模推理的AI原生存储基础设施。它基于Nvidia BlueField-4 DPU和Spectrum-X以太网网络,加速了AI原生的KV缓存访问,实现了跨节点的高速推理上下文共享,并在能效上实现了重大飞跃。![]()

随着推理从单一提示演变为跨代理的持续多回合推理,上下文保持局部的观念逐渐瓦解。性能越来越受推理历史(KV缓存)在持续负载下存储、恢复、重用、扩展和共享的效率决定——而不仅仅是GPU的计算速度。

Vast 正在通过在 Nvidia BlueField-4 DPU 上原生运行 Vast AI作系统(AI OS)软件,将关键数据服务直接嵌入执行推理的 GPU 服务器,以及专用数据节点架构,重建推理数据路径。这种设计消除了传统的客户端-服务器争用,消除了随着并发性增加而导致首次代币时间(TTFT)膨胀的多余复制和跳转。结合Vast的并行分组共享(DASE)架构,每个主机都能访问共享的、全球统一的上下文命名空间,而无需承担大规模时导致瓶颈的协调税,从而实现从GPU内存到持久NVMe存储的简化路径,通过RDMA结构实现

“推理正在变成一个记忆系统,而不是一个计算任务。赢家不会是拥有最多原始计算量的集群——它们将是能够以线速移动、共享和管理上下文的集群,“Vast Data全球技术联盟副总裁约翰·毛说。“连续性是新的表演前沿。如果上下文不能随时提供,GPU就会闲置,经济性也会崩溃。借助Nvidia BlueField-4上的Vast AI作系统,我们将上下文转化为共享基础设施——默认快速,必要时以策略驱动,并随着智能人工智能的扩展保持可预测性。”

除了原始性能,Vast还为部署Nvidia AI工厂的AI原生组织和企业提供了一条通往生产级推理协调的路径,且具备高效率和安全水平。随着推断从实验转向受监管且能驱动收入的服务,团队需要能够通过策略、隔离、可审计、生命周期控制和可选保护来管理上下文——同时保持KV缓存快速且可作为共享系统资源使用。Vast 将这些 AI 原生数据服务作为 AI作系统的一部分,帮助客户避免重建风暴,减少闲置 GPU 资源浪费,并在上下文规模和会话并发激增时提升基础设施效率。

“语境是思考的燃料。就像人类会写下来记住它们一样,人工智能代理也需要保存他们的工作成果,以便重新利用所学,“Nvidia网络高级副总裁Kevin Deierling说。“多回合和多用户推理从根本上改变了上下文记忆的大规模管理方式。配备Nvidia BlueField-4的Vast Data AI OS,支持Nvidia推理上下文内存存储平台和一个连贯的数据平面,旨在持续吞吐和可预测性能,以适应代理工作负载的扩展。”

在2026年2月24日至26日于犹他州盐湖城举办的首届用户大会Vast Forward上,体验Vast在人工智能和数据基础设施领域的领先应用。通过深入的技术课程、实践实验室和认证项目,与 Vast 的领导层、客户和合作伙伴互动。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。