Arm 公司表示该平台专为旗舰智能手机和下一代 PC 上的 AI 体验而设计。

在最近的一份公告中,Arm 发布了其新的 Lumex 高级计算子系统 (CSS) 平台,该公司表示该平台专为旗舰智能手机和下一代 PC 上的 AI 体验而设计。

在宣布新平台的博客文章中,Arm 客户业务线高级副总裁兼总经理 Chris Bergey 写道,Lumex 将公司性能最高的 CPU 与可扩展矩阵扩展版本 2 (SME2)、GPU 和系统 IP 结合在一起,使生态系统能够更快地将 AI 设备推向市场,并提供从桌面级移动游戏到实时翻译的体验, 更智能的助手和个性化的应用程序。

他还预测,到 2030 年,SME 和 SME2 将在超过 30 亿台设备上增加超过 100 亿 TOPS 的计算能力,从而实现设备上 AI 能力的指数级飞跃。

随着该版本的发布,Arm 合作伙伴可以准确选择将 Lumex 构建到其 SoC 中的方式 - 他们可以按交付方式使用该平台,并利用根据其需求量身定制的尖端物理实施,从而获得上市时间和性能优势。或者,合作伙伴可以为其目标层配置平台 RTL,并自行强化核心。

该平台结合了:

- 下一代支持 SME2 的 Armv9.3 CPU 集群,包括 C1-Ultra 和 C1-Pro,为旗舰设备提供动力

- 新型 C1-Premium,专为次旗舰市场打造,提供一流的面积效率

- 全新 Mali G1-Ultra GPU 采用下一代光线追踪,可实现高级图形和游戏,并提升 AI 性能

- Arm 迄今为止交付的最灵活、功耗感知最强的 DynamIQ 共享单元 (DSU):C1-DSU

- 针对 3nm 节点优化的物理实现

- 跨软件堆栈的深度集成,为使用 KleidiAI 库的开发人员提供无缝的 AI 加速

通过支持 SME2 的 CPU 加速 AI 无处不在

据报道,支持 SME2 的 Arm C1 CPU 集群为现实世界的 AI 驱动任务提供了显着的 AI 性能提升:

- AI 性能提升高达 5 倍

- 基于语音的工作负载的延迟降低 4.7 倍

- 音频生成速度提高 2.8 倍

Arm 表示,CPU AI 计算的这一飞跃实现了实时、设备上的 AI 推理功能,为用户提供更流畅、更快速的音频生成、计算机视觉和上下文助手等交互体验。

对于开发人员来说,AI 体验将仅在 Lumex 平台上运行。通过跨 PyTorch ExecuTorch、Google LiteRT、阿里巴巴 MNN 和 Microsoft ONNX Runtime 等主要框架的 KleidiAI 集成,应用程序无需更改代码即可自动受益于 SME2 加速。

对于构建跨平台应用程序的开发人员来说,Lumex 也旨在带来新的可移植性:

- Gmail、YouTube 和 Google Photos 等 Google 应用程序已经支持 SME2,确保在基于 Lumex 的设备上市时无缝集成

- 跨平台可移植性意味着为 Android 构建的优化可以无缝扩展到 Arm 上的 Windows 和其他平台

- 支付宝等合作伙伴已经在设备上展示了使用 SME2 高效运行的 LLM

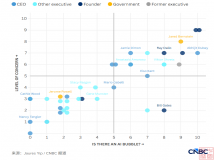

包括苹果、三星和联发科在内的技术领导者正在集成人工智能加速功能,以实现更快、更高效的设备上人工智能。Apple 正在为 Apple Intelligence 提供支持;三星和联发科正在使用 Google Gemini 提高翻译、摘要和个人助理等实时人工智能应用程序的响应能力和效率。

“SME2 增强型硬件使更先进的 AI 模型(如 Gemma 3)能够直接在各种设备上运行。随着 SME2 的不断扩展,它将使移动开发人员能够跨生态系统无缝部署下一代 AI 功能。这最终将使最终用户受益,享受在智能手机上广泛使用的低延迟体验,“谷歌 Android 杰出软件工程师 Iliyan Malchev 说。

这对于希望获得竞争优势的消费者和移动计算以及客户来说是个好消息。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。